Een schaalbaar dataplatform in Azure

TM Forum

- Klantcase

- Data Engineering

- Dataprojecten

- Analytics Engineering

TM Forum, een alliantie van meer dan 850 wereldwijde bedrijven, schakelde onze hulp in als datapartner om data gerelateerde uitdagingen te identificeren en op te lossen.

De organisatie had uitdagingen met hun data-invoer proces. De tool die ze gebruikten was een low-code oplossing met beperkte beschikbare middelen, en de meeste Data Engineers waren er niet mee bekend. Bovendien werd de tool niet gebruikt in andere afdelingen binnen TM Forum, waardoor het moeilijk was om kennis over te dragen.

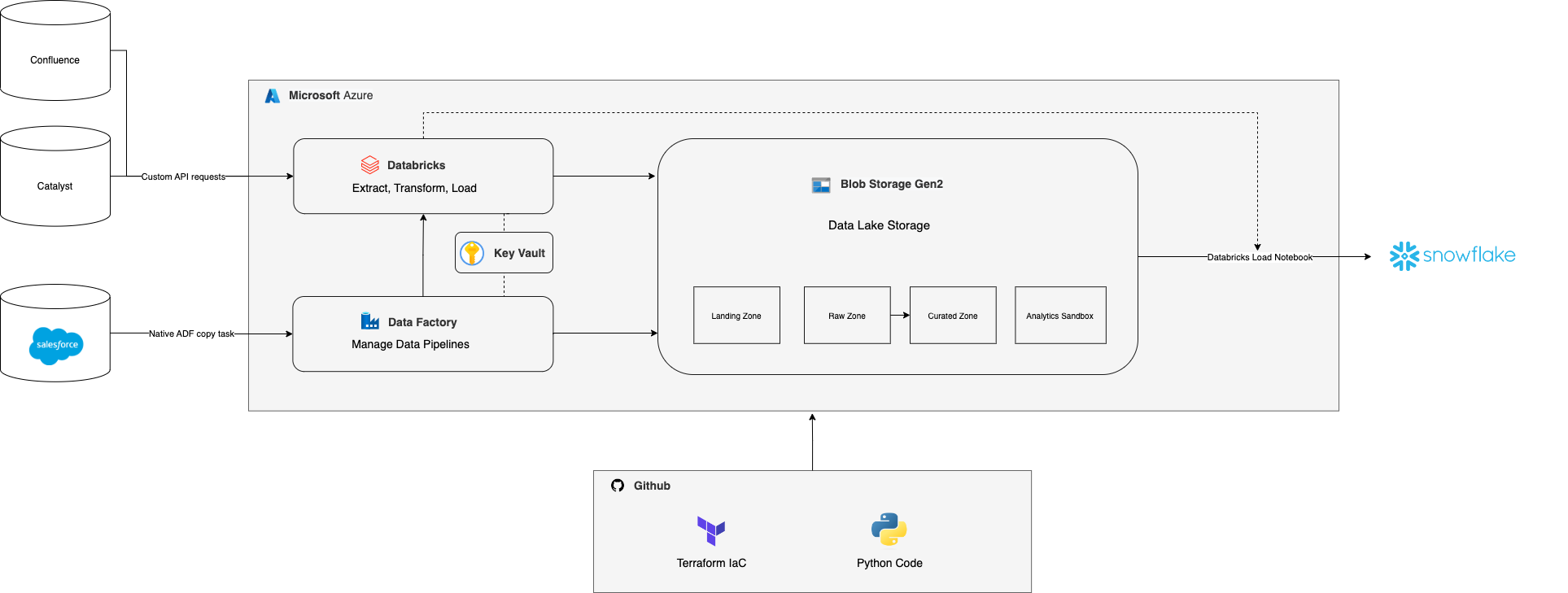

Om deze problemen aan te pakken, hebben we samen met TM Forum een schaalbaar en toekomstbestendig dataplatform opgezet in Microsoft Azure. Deze cloud provider was al in gebruik bij verschillende afdelingen binnen TM Forum, en Azure heeft goede integraties met Databricks voor big dataverwerking via Spark. De data ingestion en dataverwerking hebben we opgezet met Python code, wat overdraagbaar is en aansluit bij de vaardigheden van de gebruikers van het platform.

Aanpak

De data had betrekking op klantgegevens, events en trainingdeelname. Onze aanpak omvatte een Proof of Concept, waarbij we één van de data pipelines in Microsoft Azure opnieuw opbouwden om de haalbaarheid van onze oplossing te testen. Binnen enkele weken konden we alle functionaliteit van deze data pipeline opnieuw bouwen en een toekomstbestendige structuur opzetten.

In dit proces gebruikten we infrastructure as code viaTerraform om herbruikbare modules te creëren. Deze aanpak zorgde voor beter inzicht in de status van het platform, duidelijke documentatie en versiebeheer. Ook maakte het gemakkelijke rollbacks mogelijk in geval van pipeline-falen. Meer details over de voor- en nadelen van Infrastructure as Code vind je in onze blog.

We bouwden de data pipelines in vier stappen:

- Data inladen: via een standaard integratie (Salesforce) of een custom API-verbinding (Python code in Databricks) laadden we de data in

- Data transformeren: we verrijkten de data, trokken definities gelijk en hernoemden kolommen

- Datakwaliteit checken: we implementeerden datakwaliteitscontroles op basis van klantdefinities, zodat alleen gegevens die aan de kwaliteitsnormen voldeden in het platform werden opgenomen.

- Data pushen naar het datawarehouse in Snowflake: Analisten van TM Forum konden aan de slag met de data en waardevolle inzichten brengen

Resultaat

Alle data pipelines zijn nu geborgd in Azure en worden beheerd en gemonitord via Data Factory. De tool controleert dagelijks of alle data goed is opgehaald, getransformeerd en geverifieerd. Dit zorgt ervoor dat analisten toegang hebben tot hoogwaardige data in Snowflake en dat ze er relevante inzichten uit kunnen halen.

Toekomst

In de toekomst zullen we samen met TM Forum nagaan welke functies in het cloudplatform kunnen worden gebruikt voor analyses en welke inzichten ze willen halen uit dashboards. We zullen ook het beheer van het platform gemakkelijk overdraagbaar maken aan de interne organisatie, zodat zij het zelf kunnen onderhouden en uitbreiden.

Meer weten?

Business Manager Ian gaat graag met je in gesprek over wat we als datapartner voor jou en je organisatie kunnen betekenen.

Business Manager020 308 4390+44(0) 77 8654 1313ian.gardiner@digital-power.com

1x per maand data insights, praktijkcases en een kijkje achter de schermen ontvangen?

Meld je aan voor onze maillijst en blijf 'up to data':